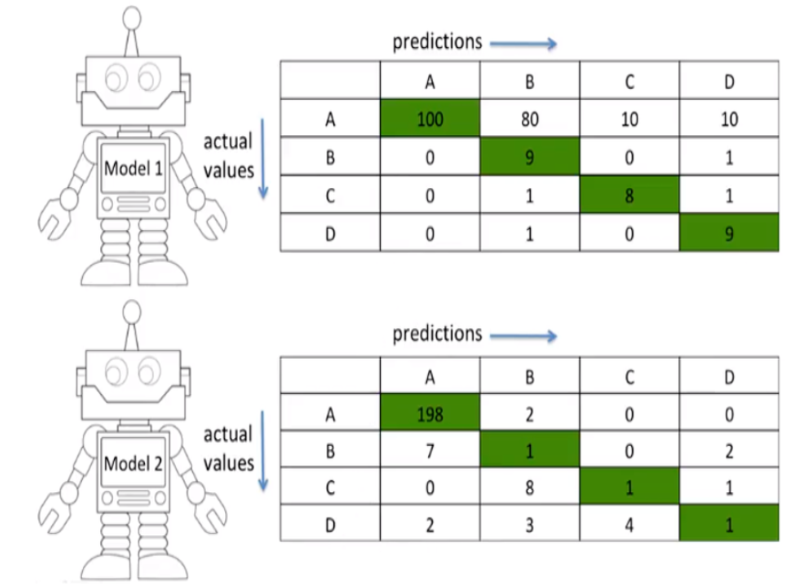

오차 행렬 (Confusion Matrix)

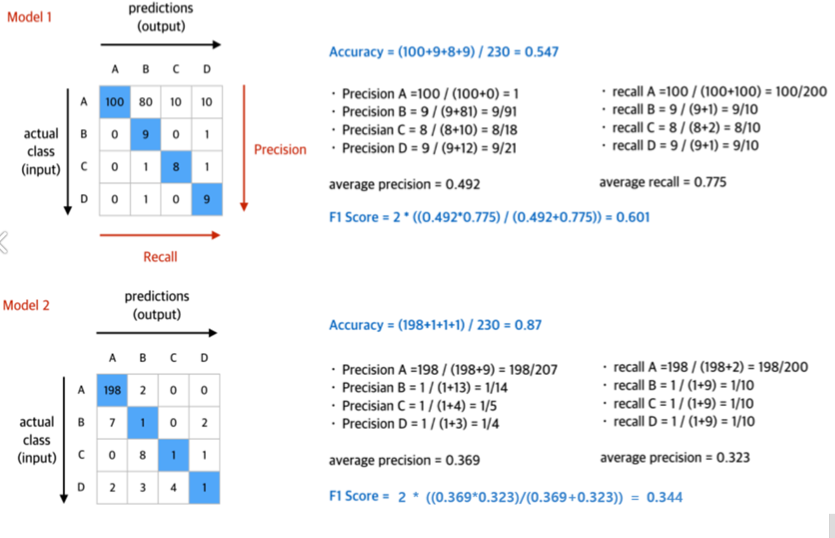

Accuracy(정확도)

균형 데이터(balanced) → accuracy를 평가 척도로 사용해도 괜찮음

불균형 데이터(imbalanced) → accuracy 만으로 성능 판단 하지 못하기때문에 Precision(정밀도)과 Recall(재현율) 사용

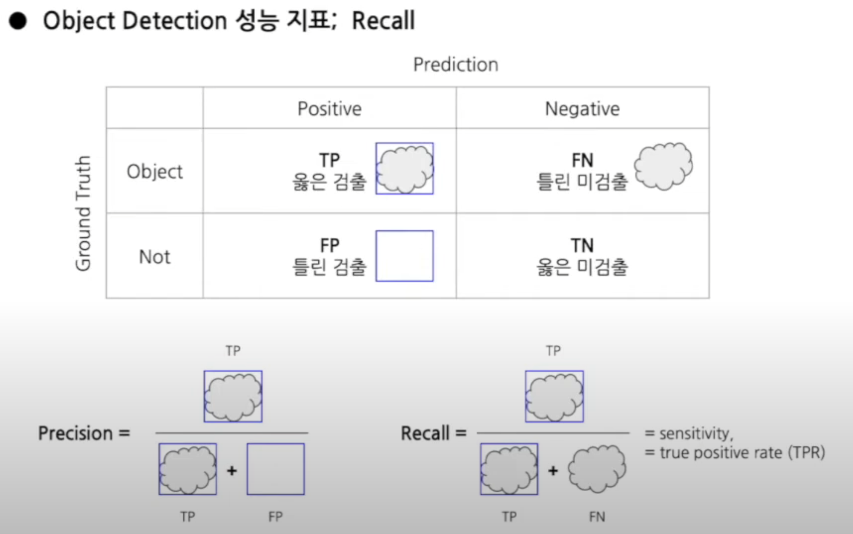

Precision(정밀도)

긍정으로 예측한 것 중 실제로 맞춘 비율

Recall(재현도)

Recall 값으로, 실제 정답을 얼마나 잘 예측했는지를 나타내는 지표

예시

A(200)B(10)C(10)D(10)

정확도=모델1(0.547)/모델2(0.87)

F1-score = 모델1(0.601)/모델2(0.34)

다중 class에서 f1-score이 구하는법

mAP

mAP는 AP(Average Precision)의 평균이고 AP는 Precision의 평균이다

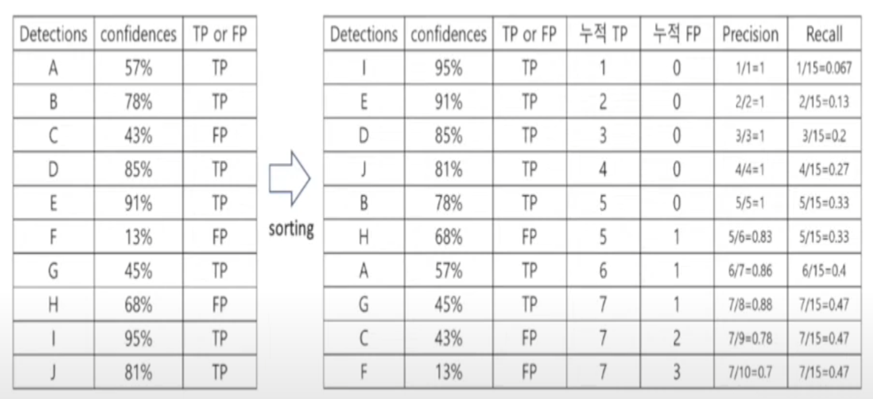

AP(평균 정밀도)

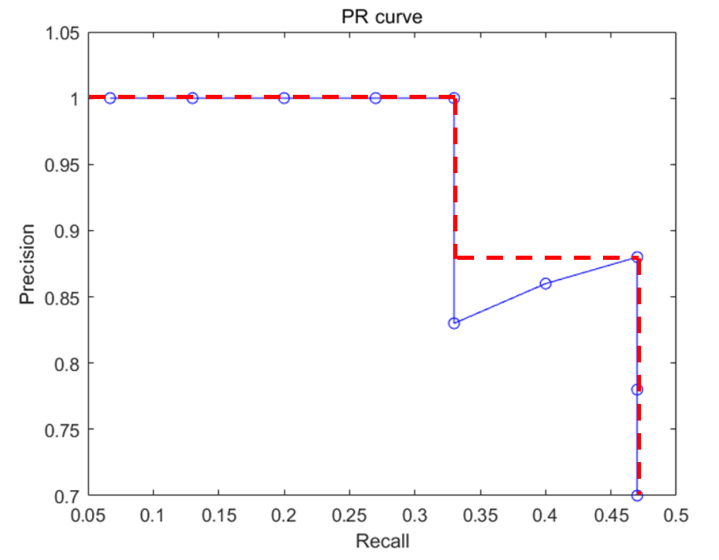

PR Curve는 confidence score에 대한 threshold 값이 변화함에 따른 Precision과 Recall의 변화량을 나타낸 그래프이다. object detection에서 confidence score는 IoU가 된다.

AP는 PR Curve의 아래 영역이 된다. AUC가 ROC curve의 아래 영역을 의미하는 것과 동일하다. Curve의 아래영역을 계산하기 쉽게 하기 위해서 PR Curve가 단조적으로 감소하도록 수정한 후 AP를 계산한다.

confidence 레벨에 대한 threshold값을 아주 엄격하게 적용해서 95%로 했다면, 하나만 검출한 것으로 판단할 것이고, 이 때 Precision = 1/1 = 1, Recall = 1/15 = 0.067이 될 것이다. threshold를 91%로 했다면 두개가 검출된 것으로 판단할 것이고, Precision = 2/2 = 1, Recall = 2/15 = 0.13이 된다.

threshold 값을 검출들의 confidence 레벨에 맞춰 낮춰가면 다음과 같이 precision과 recall이 계산된 표가 나온다.

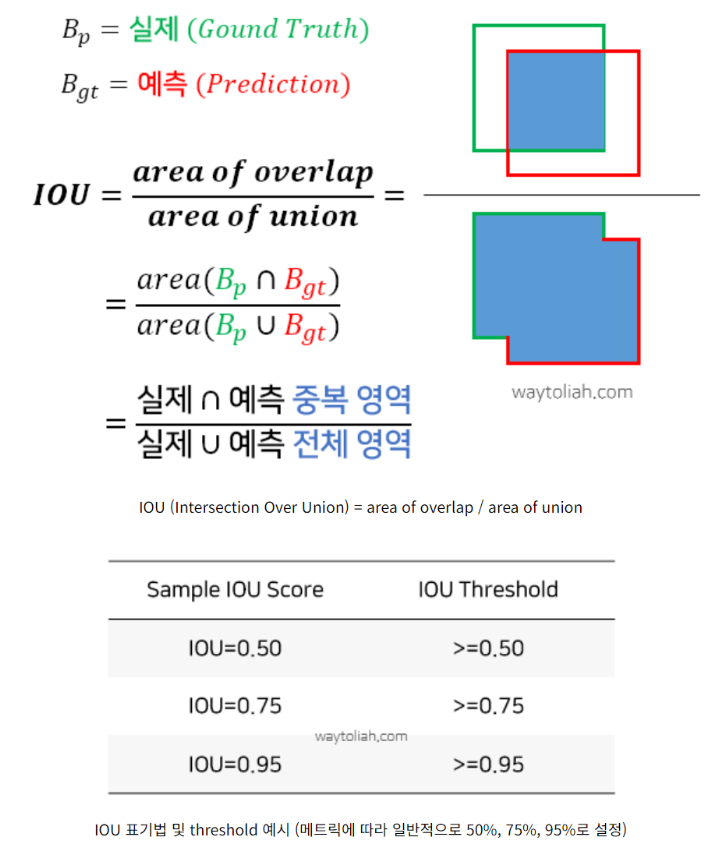

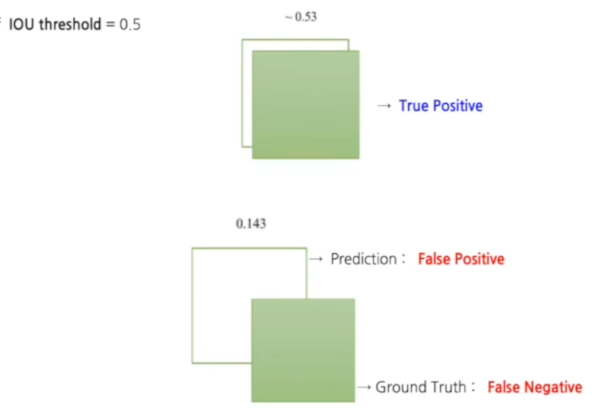

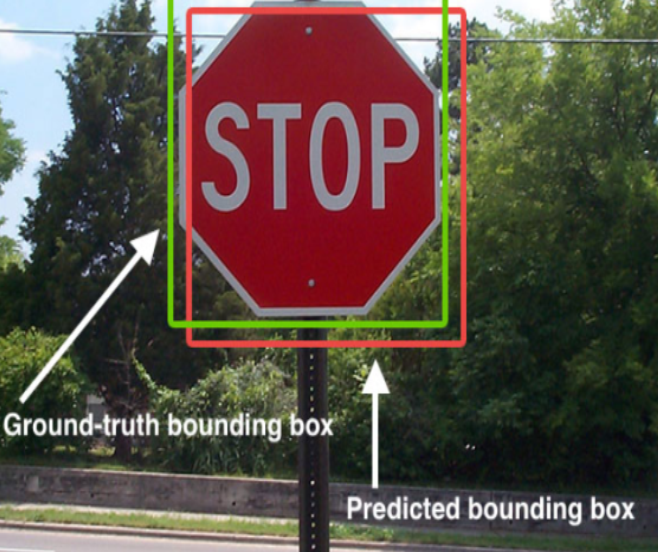

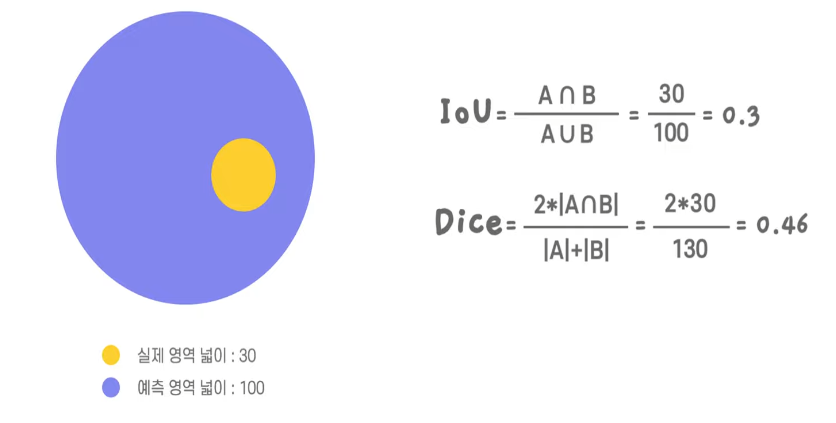

IoU

모델이 검출한 bounding box가 ground truth box와 얼마만큼 겹치는지를 나타내는 지표

IoU의 계산 결과가 0.5 이상이면 제대로 검출 되었다고 판단한다. (True Positive) 만약 0.5 미만이면 잘못 검출 되었다고 판단한다.(False Positive)

예시

IOU/DICE

dI

ss

'인공지능개론' 카테고리의 다른 글

| 이미지&객체탐지관련 알고리즘 조사 (2) | 2023.12.22 |

|---|---|

| AI에 대한 자신의 생각 정리 (2) | 2023.12.22 |

| Fine-tuning (0) | 2023.12.19 |

| 인공지능개론 - 자연어 및 자연어 처리 task 조사하기 (0) | 2023.11.06 |